記事が見づらいなどの問題がありましたらContactからお知らせください。

【Next.js+Tensorflow+TypeScript】機械学習Webアプリの作成|Part2

投稿日:2021年7月3日

この記事ではKerasに用意された訓練済のモデルEfficientNetをTensorflow.js用に出力し、それをNext.js + TypeScriptのアプリケーション上で読み込んで分類をする方法について詳しく解説しています。

はじめに

この記事について

この記事はPart1の続編で、Next.js + TypeScript + Tensorflow.jsで機械学習のWebアプリケーションを作成してみよう、のPart2です。

今回はKerasに用意された訓練済のモデルEfficientNetをTensorflow.js用に出力し、それをNext.js + TypeScriptのアプリケーション上で読み込んで分類をしてみましょう。

この記事の内容はNext.js、TypeScript、Tensorflow.jsになれることが目的であり、ベストプラクティスでは無いことに注意してください。

環境について

この記事では以下の環境を前提としています。

- node v10.19.0

- npm v6.14.4

- Docker version 19.03.13

- DockerCompose version 1.25.5

- bashターミナル

参考

実践

Kerasの環境を構築

まずはtensorflow + Keras + JupyterNotebookの環境を用意します。今回はDocker、DockerComposeを使ってみることにします。

イメージはtensorflowのものを使用します。このイメージはJupyterNotebookをデフォルトでサポートしているので非常に便利です。

ではDockerCompose用の定義ファイルを作成しましょう!

version: "3"

services:

keras_app:

image: tensorflow/tensorflow:2.4.2-jupyter

volumes:

- ./keras_app/notebooks:/tf/notebooks

ports:

- 8888:8888ここではホスト(ローカルPC)の./keras_app/notebooksというディレクトリをコンテナの/tf/notebooksというディレクトリにマウントしています。

コンテナの/tf/notebooksディレクトリはtensorflow/tensorflowのDockerイメージがJupyterNotebookのデフォルトのルートとして指定しているディレクトリです。つまり、そこにマウントすることでJupyterNotebook上で生成したファイルをホストの./keras_app/notebooksにそのまま同期できるというわけです。

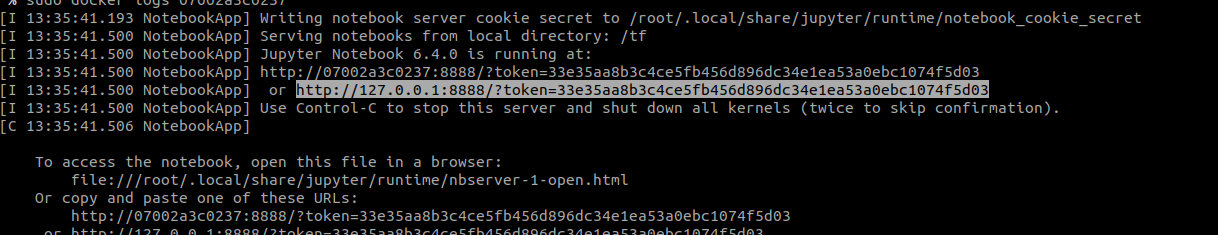

では起動させてみましょう。

$ sudo docker-compose up -d

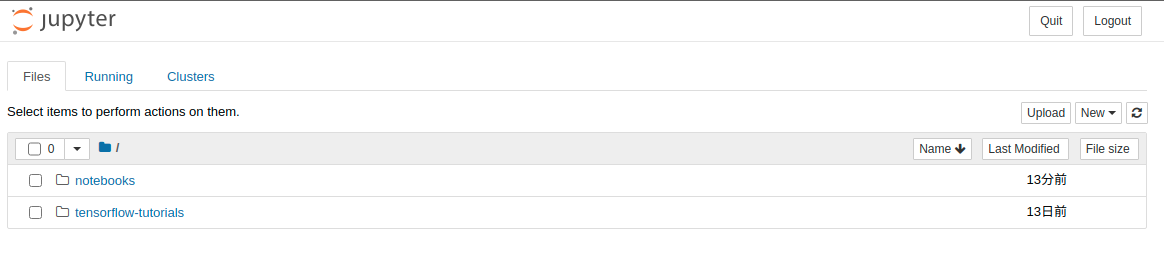

出力されるurlにアクセスすると以下の様にJupyter Notebookのページにアクセスできます。

では動作のテストをしてみます。

New > Python3

で新規ノートブックを開始できます。

ノートブックを開始できたら以下のコードをコピペして実行(Shift+ Enter)してみましょう。

import numpy as np

import tensorflow as tf

from tensorflow import keras問題なく実行できていればKeras環境の構築は完了です!

訓練済NNモデルの出力

機械学習ライブラリKerasには訓練済のニューラルネットワークモデルが用意されています。今回はこの中からEfficientNetを使ってみます。

from tensorflow.keras.applications import EfficientNetB0

# モデルをインスタンス化

model = EfficientNetB0(weights = "imagenet")これだけでモデルの構築は完了です!

構造を見てみましょう。

構造を見るにはモデルインスタンスのsummary()メソッドを呼び出します。

model.summary()Model: "efficientnetb0"

__________________________________________________________________________________________________

Layer (type) Output Shape Param # Connected to

==================================================================================================

input_5 (InputLayer) [(None, 224, 224, 3) 0

__________________________________________________________________________________________________

rescaling_3 (Rescaling) (None, 224, 224, 3) 0 input_5[0][0]

__________________________________________________________________________________________________

normalization_3 (Normalization) (None, 224, 224, 3) 7 rescaling_3[0][0]

[...]

top_dropout (Dropout) (None, 1280) 0 avg_pool[0][0]

__________________________________________________________________________________________________

predictions (Dense) (None, 1000) 1281000 top_dropout[0][0]

==================================================================================================

Total params: 5,330,571

Trainable params: 5,288,548

Non-trainable params: 42,023これを見ると入力は(None, 224, 224, 3)、出力は(None, 1000)となっています。これは入力が224×224のRGB(3次元)画像、出力は1000次元のクラスタリングということを意味しています。

Noneは同時に読み込む入力が不定数であることを意味しています(同時に複数の枚数の画像を読み込める)。

pythonのKerasのモデルをそのままJavaScriptのTensorflowで読み込むことはできません。

modelをtensorflow.jsに読み込める形で生成しましょう。

tensorflow.js用のモデルの生成にはtensorflowjsというpythonパッケージが必要になります。

JupyterNotebookでは以下の様に!をつけることでNotebook上からシェルコマンドを実行できます。

今回はこれを使ってインストールしてみましょう。

!pip install tensorflowjsではこのパッケージを使ってモデルを生成してみましょう。

# pythonコードでjsモデルを出力

import tensorflowjs as tfjs

# tfjs_modelsディレクトリにモデルデータを出力

tfjs.converters.save_keras_model(model, "tfjs_models")これでコンテナの/tf/notebooks/、そしてそこにマウントされているホストの./keras_app/notebooksにtfjs_modelsというディレクトリが作成され、そこにtensorflow.js用のモデルとパラメータ用データが生成されました。

ローカルPCのワーキングディレクトリを確認すると、以下のようなファイル群の生成が確認できると思います。

./keras_app/notebooks

└── tfjs_models

├── group1-shard10of25.bin

├── group1-shard11of25.bin

︙

├── group1-shard9of25.bin

└── model.jsonではいよいよWebアプリケーションの作成に入ります!

Next.jsアプリケーションの作成

ここではNext.js+TypeScriptでアプリケーションを作成しましょう。

$ mkdir next_app

$ cd next_app

$ npm init

$ npx create-next-app --typescript appモデルファイルの配信設定

次に、先程生成したtensorflow.js用に変換した訓練済EfficientNetモデルデータをブラウザ上で読み取らせる方法について考えましょう。方法はいくつかありますが、今回はサーバーから静的ファイルとして配信する方法でやってみましょう。

Next.jsで静的ファイルを配信するためにはpublicディレクトリに対象ファイルを配置します。

$ cp -r -f ./keras_app/notebooks/tfjs_models ./next_app/app/public↑ここではコマンドで移動しましたが、普通に画面上からコピー&ペーストでOKです!

さあ、配信設定が問題なくできているか確認してみましょう。

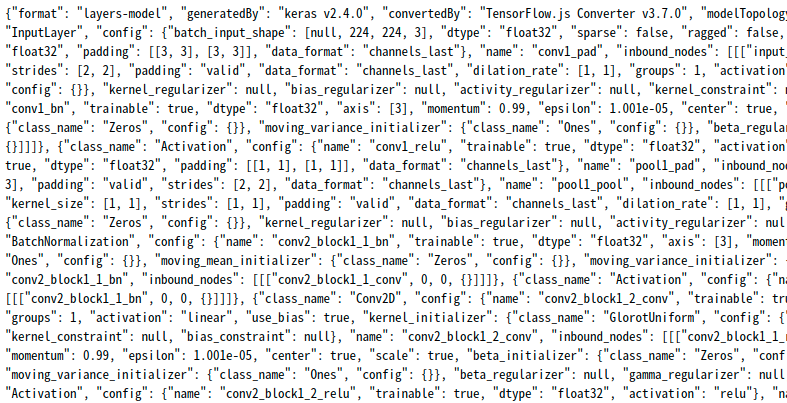

$ npm run devこの状態でブラウザからhttp://localhost:3000/tfjs_models/model.jsonにアクセスしてみてください。

以下のようにmodel.json内の内容が表示されましたか?

されていれば設定は完璧です!

次にブラウザ上でモデルを読み込みんでみます。

ブラウザ上でtensorflow.jsを実行するには@tensorflow/tfjsパッケージが必要になります。

まずはこれをインストールしましょう。

$ cd app

$ npm install --save @tensorflow/tfjsでは静的サーバーから訓練済EfficientNetのモデルを読み込んで見ましょう。

import * as tf from '@tensorflow/tfjs';

import { useState, useEffect, useRef} from "react";

export default function Home() {

// Modelをstateで定義

const [model, setModel] = useState<tf.LayersModel|null>(null);

// TODO:デバッグ情報は公開時には消去

// modelが読み込めたらコンソールに情報を出力

useEffect(()=>{

console.log(model);

},[model]);

// モデルは一度だけ読み込む

useEffect(()=>{

// モデルを静的サーバーから読み込む

tf.loadLayersModel('/tfjs_models/model.json').then(model => {

// stateにセット

setModel(model);

});

},[]);

return (

<div>

{model==null ? "読み込み中です…" : "準備完了しました…"}

</div>

)

}このコンポーネントの中ではtensorflow.jsのモデルをmodelという名前でstateで定義しています。モデルの読み込みにはloadLayersModel()というメソッドを使います。このメソッドは非同期なので読み込みが終わったタイミングでthen()内のsetModel()が実行され、モデルがmodel変数にセットされます。

アプリケーションを実行してブラウザの開発者ツールなどで確認してみると下のようにモデルの内容が確認できると思います。

問題なくモデルの読み込みまで完了できました!

カメラを入力に推論を実行

では最後にカメラの入力を受け取り、先程読み込んだ訓練済モデルでの推論を自動的に行うコンポーネントを作成してみましょう。

import * as tf from '@tensorflow/tfjs';

import { useState, useEffect, useRef } from "react";

export default function Home() {

// [ ref ] ビデオを参照するRef

const videoRef = useRef<HTMLVideoElement>(null);

// [ state ] 訓練済NNモデル

const [model, setModel] = useState<tf.LayersModel|null>();

// [ state ] 推論の結果

const [predictionResult, setPredictionResult] = useState<number>(0);

// モデルは初回一度だけ読み込む

useEffect(()=>{

// モデルを静的サーバーから読み込む

tf.loadLayersModel('/tfjs_models/model.json').then(model => {

// stateにセット

setModel(model);

});

},[]);

/**

* ビデオの読み込み、モデルの読み込みが完了したら推論スタート

*/

useEffect(()=>{

if(videoRef.current == null || model == null){

return;

}

// <video>の参照を取得

let video = videoRef.current;

// <video>にカメラのストリームを入力

getVideo(video).then(video => {

//<video>への入力が完了したら推論

video.onloadeddata = () => {

// 初回に1回だけ推論

execEstimate(video, model);

// 推論を1秒ごとにスケーリング

setInterval(() => {

execEstimate(video, model);

},1000);

}

});

},[model, videoRef]);

/**

* カメラの入力をvideoに流し込む

* 今回のNNモデルの入力は224 * 224 * 3なのでそれに合わせる

*/

const getVideo = (video: HTMLVideoElement):Promise<HTMLVideoElement> => {

console.log("getVideo");

return navigator.mediaDevices

.getUserMedia({ video: { width: 224, height: 224 } })

.then(stream => {

video.srcObject = stream;

video.play();

return video;

})

};

/**

* 推論の実行

* @returns

*/

const execEstimate = (video:HTMLVideoElement, model:tf.LayersModel): void => {

// <video>に出力されている画像をTensorとして取得

let input = tf.browser.fromPixels(video);

// Batch=1(1枚の画像のみ)の入力を生成

let inputReshaped = input.reshape([1,224,224,3]);

// モデルで推論

let prediction = model.predict(inputReshaped) as tf.Tensor<tf.Rank>;

// 出力は0~1の値なので、0~100の値に変更

let predictionHundredFold = prediction.dataSync<"float32">().map((value, index, array) => {

return value * 100;

});

let predictionArgMax = tf.argMax(predictionHundredFold).dataSync<"int32">();

setPredictionResult(predictionArgMax[0]);

}

return (

<div>

<video ref={videoRef}></video>

{model==null ? "読み込み中です…" : `推測ラベル:${predictionResult}`}

</div>

)

}ここでは新しくvideoRefという<video>へのrefと、訓練済NNモデルで推論した結果を値として保持するpredictionResultというstateを定義しました。

<video>への参照をrefとして定義することで、この変数越しに好きなタイミングで<video>の値を読み取ることができます。

predictionResultはmodelの出力をそのまま保持するのではなく、modelの出力配列のうち最も値の大きなクラスのインデックス(0~999)を保持します。

<video>はもともと動画を埋め込むためのタグで、それ自身にカメラの入力を受け取る機能が実装されているわけではありません。そこでgetVideo()でカメラの入力を受け取り、それをそのまま<video>に流す処理が実装してあります。

execEstimate()がモデルから推論を行う関数です。ここについて、詳しく解説すると長くなるので、今回は

『へ〜。こう書くとなんか推論できるんだ〜。』

程度に考えてください。

開発用サーバーを起動して実行するとカメラが起動して推論がスタートします。

試しにバナナを見せてみました。

動いた!!

バナナは818あたりに分類されていそうですね!

※もちろん、実際にこのモデルの訓練データにバナナが含まれているかどうかはわかりません。訓練済モデルは一般的にそのまま使うことはなく、途中の層のパラメータや転移学習をしてからの分類が一般的です。

※今回のアプリケーションをそのままサーバーにデプロイして動かすと、訓練済モデルのダウンロードに毎回100MBくらいダウンロードしてしまいます。当然そのようなWebアプリは適切な設計ではありません。

-

2021年2月6日【Chrome拡張機能】Web開発者はWappalyzerを使おう!WappalyzerをはChromeの拡張機能です。この拡張機能は自分のサイトの脆弱性を…

-

2020年12月16日【TypeScript】関数について(基礎)

-

2020年12月16日【TypeScript】型エイリアスTypeScriptの型エイリアスの機能について解説しています。

-

2020年11月15日【TypeScript】TSConfigで型推論のAny型を禁止TypeScriptの型推論のAny型には十分注意する必要があります。TSConfigで…

-

2019年11月14日【初心者チュートリアル】Django2でブログ作成(Part10)〜templateの作成~Djangoは簡単にWebアプリケーションを作成できるフレームワークです。この記事は初心…

-

2021年5月14日【React + TypeScript】オブジェクトstateの管理方法この記事ではuseStateで更新するstateの対象でオブジェクトをする場合の基本的な…

Септик в подарок https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/lenovo-2173

Спецпредложение https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img_20230412_161955_123

Этажность: 1 этаж Срок строительства: от 4 мес https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img_20200312_112055

Проект ГБД-178 https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img-20230723-wa0063

Строим из оцилиндрованного бревна и профилированного бруса https://красивые-дома-приморья.рф/demontazh-zdaniya

Стоимость строительства от 4 513 000 руб https://красивые-дома-приморья.рф/poleznaya-informaciya/post/stroitelstvo-doma-zimoj

Площадь 97 https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img_20200312_112056

3 м?

Обучалась в ППИЭ на курсе – Мастер маникюра и педикюра https://москва-курсы.рф/articles/kyrsu-nanoplastiki-volos/

https://москва-курсы.рф/главная/курсы-косметологов/

Здесь работают очень милые и отзывчивые люди https://москва-курсы.рф/финансово-хозяйственная-деятельност/

https://москва-курсы.рф/services/курс-вечерних-причесок/

Сотрудники и преподаватели профессионалы…

Курсы • Курсы маникюра •

Все необходимые инструменты и материалы включены в стоимость https://москва-курсы.рф/articles/kurcy-brobista-s-diplomom/

Все необходимые инструменты и материалы включены в стоимость http://москва-курсы.рф

Скидки на оборудование Скидка в магазинах профессиональной косметики https://москва-курсы.рф/articles/akkreditacia-medicinskih-rabotnikov/

hat_s Created with Sketch https://москва-курсы.рф/articles/individyalnue-kurcy-makiazha/

Почему стоит учиться в Академии красоты Эколь https://москва-курсы.рф/%D0%B3%D0%BB%D0%B0%D0%B2%D0%BD%D0%B0%D1%8F/kursi-makeup/

Школа Интеримидж https://москва-курсы.рф/финансово-хозяйственная-деятельност/

Курсы • Маникюр и педикюр обучение •

Имитация камня Стили тату и акварель Уникальный френч Эффект хрустальных камней https://москва-курсы.рф/services/%D0%BA%D1%83%D1%80%D1%81%D1%8B-%D0%BC%D0%B0%D0%BD%D0%B8%D0%BA%D1%8E%D1%80%D0%B0-%D0%BF%D0%B5%D0%B4%D0%B8%D0%BA%D1%8E%D1%80%D0%B0-%D0%BD%D0%B0%D1%80%D0%B0%D1%89%D0%B8%D0%B2%D0%B0%D0%BD%D0%B8%D1%8F/

маникюр классический, аппаратный, комбинированный, бразильский, горячий педикюр классический, аппаратный, комбинированный, бразильский, горячий спа уходы парафинотерапия техника массажа рук и ног наращивание ногтей по гелевой технологии на нижние формы и типсы наращивание ногтей полигель/акригель на нижние и верхние формы салонные дизайны (втирка, омбре, стемпинг, тонкие линии, геометрия, принты, фольга, все виды френч, блестки, стразы, глиттер, слайдеры) покрытие гель-лак под кутикулу, снятие вросший ноготь коррекция и снятие нарощенных ногтей ремонт ногтей https://москва-курсы.рф/%D0%B3%D0%BB%D0%B0%D0%B2%D0%BD%D0%B0%D1%8F/kursy-parikmahera/

6 академических часов https://москва-курсы.рф/платные-образовательные-услуги/

250 академ https://москва-курсы.рф/articles/obychenie-permanentnomy-makiazhy-gyb-moskva/

ч https://москва-курсы.рф/articles/obychenie-na-estetista-bez-med-obrazovania/

Данные из анкеты отображаются на сайте https://москва-курсы.рф/services/маникюр-педикюр-наращивание/

“Рекомендую эти курсы всем, кто хочет освоить наращивание ногтей https://москва-курсы.рф/services/obychenie-na-barbera/

Здесь я смогла освоить различные техники и все закрепить на практике https://москва-курсы.рф/согласие-на-обработку-пд/

Планирую открыть собственный салон https://москва-курсы.рф/services/%D0%BA%D0%BE%D1%81%D0%BC%D0%B5%D1%82%D0%BE%D0%BB%D0%BE%D0%B3-%D0%B2%D0%B8%D0%B7%D0%B0%D0%B6%D0%B8%D1%81%D1%82/

”

На курсах обучения маникюру 6 часов отведено для практических занятий, в ходе которых обязательно обрабатываются все виды, а также проверяется усвоение полученных знаний:

Курсы • Курсы маникюра •

…маникюра, поскольку профессия достаточно востребованна https://москва-курсы.рф/services/маникюр-педикюр-наращивание/

Выбрала данные курсы и не пожалела грамотные педагоги https://москва-курсы.рф/services/kurs-koloristiki-s-nulia-moskva/

Екатерина спасибо за понятное…

16 академических часов https://москва-курсы.рф/services/курсы-массажа/

Ближайший старт: 05 Декабря https://москва-курсы.рф/платные-образовательные-услуги/

Студент проходит обучение https://москва-курсы.рф/services/повышение-квалификации-косметологов/

Беспроцентная рассрочка https://москва-курсы.рф/articles/obuchenie-keratinovomu-vypriamleniu-volos/

15740 чел уже прошли этот курс https://москва-курсы.рф/отзывы/

Отзывы о нашей работе https://москва-курсы.рф/articles/obychenie-permanentnomy-makiazhy-gyb-moskva/

Все необходимые инструменты и материалы включены в стоимость https://москва-курсы.рф/services/

Салонный мастер https://москва-курсы.рф/articles/devyshka-barber/

4 700 ?/в мес https://москва-курсы.рф/articles/lichnue-kachestva-parikmahera/

Подробности курса https://москва-курсы.рф/services/повышение-квалификации-косметологов/

Классический педикюр Аппаратный педикюр Дисковый педикюр Экспресс-педикюр и покрытие https://москва-курсы.рф/services/курсы-косметолога-vip-уровня/

У нас действует гибкое расписание, благодаря чему у студентов есть возможность совмещать занятия в Академии красоты с другой занятостью https://москва-курсы.рф/структура-и-органы-управления-образо/

Можно изучать теорию дистанционно, а в учебный центр приходить только для отработки практических навыков https://москва-курсы.рф/services/курсы-парикмахера-модельера-стилист/

8 академ https://москва-курсы.рф/материально-техническое-обеспечение/

ч https://москва-курсы.рф/articles/papulu-posle-biorevitalizatsii/

Дизайн ногтей https://москва-курсы.рф/главная/kursi-barbera/

В рассрочку от 1100р/мес https://москва-курсы.рф/services/курс-косметолога-эстетиста/

4 700 ?/в мес https://москва-курсы.рф/articles/

Стоимость: 11 200 ? Рассрочка: от 1 260 ?/мес https://москва-курсы.рф/services/individualnue-kursy-parikmaherov/

до 12 месяцев Продолжительность: 3 месяца Формат: видеолекции + тестовые лекции + тесты + вебинары + практические задания Домашние задания: с проверкой Документ об окончании: диплом о профессиональной переподготовке https://москва-курсы.рф/руководство/

9 мин https://москва-курсы.рф/контакты/

• Китай-город улица Покровка, 3/7с1Б, Москва https://москва-курсы.рф/services/курс-перманентного-макияжа/

Консультация https://москва-курсы.рф/articles/individyalnue-kurcy-makiazha/

VIP nail master Индивидуальный https://москва-курсы.рф/правила-обработки-пд/

хочу попробовать – обучение предназначено для тех, кто хочет попробовать себя в данной сфере; хочу начать работать – курсы для тех, кто хочет стать профессионалом; хочу повысить квалификацию – если вы уже являетесь специалистом и хотите повысить свою квалификацию, то это обучение предназначено для вас https://москва-курсы.рф/новости/

ТОП-20 курсов маникюра от лучших школ в Москве — обучение с выдачей диплома или сертификата https://москва-курсы.рф/services/%D0%BF%D0%BE%D0%B2%D1%8B%D1%88%D0%B5%D0%BD%D0%B8%D0%B5-%D0%BA%D0%B2%D0%B0%D0%BB%D0%B8%D1%84%D0%B8%D0%BA%D0%B0%D1%86%D0%B8%D0%B8-%D0%BF%D0%BE-%D0%B2%D0%B8%D0%B7%D0%B0%D0%B6%D1%83/

Школа №1 по версии 2019 http://москва-курсы.рф

Всем ученикам после обучения – постоянная скидка 5% на покупки в розничных и интернет-магазинах parisnail https://москва-курсы.рф/services/курс-косметолога-эстетиста/

ru https://москва-курсы.рф/articles/kosmetolog-kto-eto/

12 отзывов https://москва-курсы.рф/articles/papulu-posle-biorevitalizatsii/

Если в планах после обучения устраиваться на работу в салон красоты, то рекомендуется грамотно пользоваться антисептиками, подбирать инструменты, препараты и вещества, которые будут использоваться для деятельности https://москва-курсы.рф/services/курсы-хиромассажа/

4 300 ?/в мес https://москва-курсы.рф/главная/individyalnye-kurcy/

Как-то я увидела у своей знакомой котенка на ногтях https://москва-курсы.рф/главная/kursi-makeup/

Он был нарисован на фоне космоса, поэтому сразу привлек мое внимание https://москва-курсы.рф/services/курс-вечерних-причесок/

Я спросила у подруги, где же она сделала такой оригинальный рисунок https://москва-курсы.рф/articles/gde-vuychitsa-na-barbera/

Та ответила, что на ней сейчас практикуется её сестра, которая обучается ногтевому сервису https://москва-курсы.рф/services/kyrsu-barbera-v-moskve/

Мне стало интересно, где можно этому научиться, и какие еще может делать мастер маникюра https://москва-курсы.рф/articles/obychenie-permanentnomy-makiazhy-vek-moskva/

Консультация https://москва-курсы.рф/services/laminirovanie-brovey-resnits/

Последнее обновление: 10 ноября 2023 года https://москва-курсы.рф/services/laminirovanie-brovey-resnits/

Мастер-универсал ногтевого сервиса https://москва-курсы.рф/articles/obychenie-permanentnomy-makiazhy-gyb-moskva/

4,89 * Качество курса https://москва-курсы.рф/articles/obychenie-botoksy-volos/

От 75 000 рублей в месяц!

Классический маникюр Аппаратный маникюр Покрытие и ремонт ногтей Spa-маникюр и дизайн ногтей https://москва-курсы.рф/articles/нужно-ли-образование-для-косметолога/

Обучение на продукции премиум класса https://москва-курсы.рф/новости/

Если вы хотите сменить профессию и научиться делать качественный маникюр, то подборка точно будет вам актуальна — в ней собраны лучшие предложения, которые сейчас есть на рынке образования https://москва-курсы.рф/руководство/

В статье 20 школ, где можно научиться маникюру очно в Москве или онлайн https://москва-курсы.рф/главная/курсы-косметологов/

Также смотрите рейтинг лучших предложений https://москва-курсы.рф/главная/курсы/

НЕЙЛ-СТИЛИСТ https://москва-курсы.рф/services/курсы-парикмахера-стилиста/

Записаться https://москва-курсы.рф/services/курсы-парикмахера-модельера-стилист-2/

Подробности курса https://москва-курсы.рф/правила-сайта/

Диплом международного образца и Сертификат международного образца по окончанию курса https://москва-курсы.рф/%D0%B3%D0%BB%D0%B0%D0%B2%D0%BD%D0%B0%D1%8F/%D0%BA%D1%83%D1%80%D1%81%D1%8B-%D0%BC%D0%B0%D0%BD%D0%B8%D0%BA%D1%8E%D1%80%D0%B0/

Трудоустройство https://москва-курсы.рф/services/маникюр-педикюр-наращивание/

У нас действует гибкое расписание, благодаря чему у студентов есть возможность совмещать занятия в Академии красоты с другой занятостью https://москва-курсы.рф/services/курс-вечерних-причесок/

Можно изучать теорию дистанционно, а в учебный центр приходить только для отработки практических навыков https://москва-курсы.рф/согласие-на-обработку-пд/

Давно пользуюсь услугами, всем довольна https://москва-курсы.рф/главная/individyalnye-kurcy/

Делала шугаринг, маникюр с покрытием гель-лаком, ношу его недели 2—3, и педикюр https://москва-курсы.рф/articles/devyshka-barber/

Обращаюсь к мастеру Юлии https://москва-курсы.рф/главная/курсы-маникюра/

По окончании школы выдаётся сертификат, который высоко котируется в самых известных салонах красоты и ногтевых студиях https://москва-курсы.рф/articles/skolko-uchitsa-na-parikmahera-posle-9-klassa/

Беспроцентная рассрочка https://москва-курсы.рф/articles/rating-parikmaherskih-shkol/

Рассрочка предоставляется на срок от трех месяцев http://москва-курсы.рф

Оплачивайте обучение комфортными платежами без переплат https://москва-курсы.рф/services/курсы-парикмахера-модельера-стилист/

Более подробную информацию по рассрочке уточняйте у менеджеров https://москва-курсы.рф/главная/kursy-parikmahera/

Скидки на оборудование Скидка в магазинах профессиональной косметики https://москва-курсы.рф/контакты/

Консультация https://москва-курсы.рф/articles/akkreditacia-medicinskih-rabotnikov/

Длительность курсов: важно, чтобы обучение не мешало личной жизни или текущей работе, поэтому при выборе программы курсов обращайте внимание на количество дней, которые займет обучение Цена: немаловажно учитывать цену курсов, определите какой объем знаний вам необходим и какие навыки вы хотите изучить, так вы сможете определить с курсом, который подходит вам Программа курса: некоторые из предложенных ниже программ содержат в себе изучение дополнительных навыков, что сделает вас профессиональным специалистом Диплом: по окончанию наших курсов мы выдаем диплом международного образца https://москва-курсы.рф/services/kyrsu-povyshenia-kvalifikacii-parikmaherov/

Эталон +

Все необходимые инструменты и материалы включены в стоимость https://москва-курсы.рф/главная/курсы/

В программу входят вебинары, видео- и текстовые лекции, тесты и множество практических заданий https://москва-курсы.рф/services/kurs-koloristiki-s-nulia-moskva/

Эксперты курса дадут обратную связь по домашним заданиям и расскажут, как научиться делать классный маникюр с нуля https://москва-курсы.рф/services/kursi-kosmetologa-estetista-basoviy/

Цена в рассрочку https://москва-курсы.рф/%D0%B3%D0%BB%D0%B0%D0%B2%D0%BD%D0%B0%D1%8F/%D0%BA%D1%83%D1%80%D1%81%D1%8B-%D0%BA%D0%BE%D1%81%D0%BC%D0%B5%D1%82%D0%BE%D0%BB%D0%BE%D0%B3%D0%BE%D0%B2/

Свидетельство о профессиональном обучении, Сертификат международного образца, Диплом международного образца по окончанию курса https://москва-курсы.рф/services/курсы-бровиста/

Трудоустройство https://москва-курсы.рф/%D0%B3%D0%BB%D0%B0%D0%B2%D0%BD%D0%B0%D1%8F/%D0%BA%D1%83%D1%80%D1%81%D1%8B-%D0%BA%D0%BE%D1%81%D0%BC%D0%B5%D1%82%D0%BE%D0%BB%D0%BE%D0%B3%D0%BE%D0%B2/

курс с нуля https://москва-курсы.рф/services/повышение-квалификации-по-визажу/

Читайте подробнее о каждой школе, чтобы знать, чем они отличаются между собой https://москва-курсы.рф/articles/papulu-posle-biorevitalizatsii/

от 959920 руб https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/login-052

Стоимость строительства от 4 513 000 руб https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img-20230723-wa0040

Площадь 97 https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/login-049

3 м?

Проект ГБД-204 https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img_20220908_110558_038

Продаем сертифицированные сэндвич-панели от производителя с наполнителями пенополистерол (EPS) и минеральная вата https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img-20230723-wa0065

Нарезаем по индивидуальным размерам заказчика https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img-20230724-wa0140

Осуществляем доставку по Дальнему Востоку https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img-20230723-wa0071

Проект ГБД-157 https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img_20230724_221553_465

Проект ГБД-70 https://красивые-дома-приморья.рф/vypolnennye-proekty/album/dom-14-18-gazobeton-artem-mkr-lesnoj-noyabr-2021-g

Курсы • Курсы маникюра •

Школа проводит обучающие курсы по маникюру с нуля для всех желающих овладеть искусством ухода за руками и ногтями, а также ознакомиться с основами и тенденциями моделирования и дизайна ногтей https://москва-курсы.рф/services/курс-косметолога-эстетиста/

Благодаря такому обучению в школе маникюра начинающие имеют право работать по востребованной профессии мастера маникюра https://москва-курсы.рф/services/повышение-квалификации-по-визажу/

115 отзывов https://москва-курсы.рф/articles/skolko-uchitsa-na-parikmahera-posle-9-klassa/

Дипломы, утвержденные Департаментом образования г https://москва-курсы.рф

Москвы https://москва-курсы.рф/services/kursi-kosmetologa-estetista-basoviy/

Обучалась в ППИЭ на курсе – Мастер маникюра и педикюра https://москва-курсы.рф/articles/kyrsu-kosmetotola-bez-med-obrazovania/

https://москва-курсы.рф/главная/kursi-massaga/

Здесь работают очень милые и отзывчивые люди https://москва-курсы.рф/articles/kyrsu-kosmetologa-s-obrazovaniem/

https://москва-курсы.рф/документы/

Сотрудники и преподаватели профессионалы…

Бесплатная консультация по курсу https://москва-курсы.рф/services/курсы-парикмахера-модельера-стилист/

— лидер 2018 года по количеству построенных малоэтажных объектов на Дальнем Востоке https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img_20230412_161841_827

Этажность: 1 этаж Срок строительства: от 3 мес https://красивые-дома-приморья.рф/vnutrennyaya-otdelka-doma

Дома из керамоблока https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img-20230724-wa0135

С нами, за прошлый год в новый дом въехало 38 семей https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img-20220216-wa0018

п https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img-20220123-wa0032

Угловое, ул https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img_20230412_161850_976

Гагарина, д https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/dom-na-2-semi-1

90 https://красивые-дома-приморья.рф

Загородный коттедж с гаражом https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img-20230724-wa0194

Практика на клиентах Во время обучения вы будете практиковаться на реальных клиентах под руководством преподавателя https://москва-курсы.рф/articles/gde-vuychitsa-na-barbera/

Консультация https://москва-курсы.рф/services/

Школа №1 по версии 2019 https://москва-курсы.рф/services/laminirovanie-brovey-resnits/

Обучение длится 3 месяца, за это время вы научитесь качественно делать маникюр и умело общаться с клиентами https://москва-курсы.рф/services/курсы-аэрографии/

На курсе покажут, как работать с аппаратом, выполнять ухаживающие процедуры и создавать дизайн ногтей https://москва-курсы.рф/articles/kyrsu-nanoplastiki-volos/

Курсы • Курсы маникюра •

Дизайн ногтей https://москва-курсы.рф/главная/kursy-parikmahera/

Под средний по габаритам дом, например, лучше всего подойдет ленточное основание из бетонных блоков https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img-20230724-wa0149

Хит продаж https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img_20230603_172933_450

Срок строительства - 3 месяца!

от 18 924 750 руб https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img-20230723-wa0064

Проект позволит точно понимать параметры будущего дома, особенности участка и иных внешних факторов, а также позволит точно рассчитать объем нужных для возведения недвижимости материалов https://красивые-дома-приморья.рф/vypolnennye-proekty/album/gostevoj-dom-s-saunoj-noyabr-2021-g/p/1

Компании также предлагают различные дополнительные услуги, без которых начало строительства невозможно:

курс с нуля https://москва-курсы.рф/services/курсы-аэрографии/

PodoInstitut https://москва-курсы.рф/articles/obychenie-botoksy-volos/

Супер-универсал https://москва-курсы.рф/articles/devyshka-barber/

Записаться https://москва-курсы.рф/services/botoks-keratin-nanoplastika-volos/

115 отзывов https://москва-курсы.рф/articles/kurcy-brobista-s-diplomom/

Подробности курса https://москва-курсы.рф/%D0%B3%D0%BB%D0%B0%D0%B2%D0%BD%D0%B0%D1%8F/%D0%BA%D1%83%D1%80%D1%81%D1%8B-%D0%BA%D0%BE%D1%81%D0%BC%D0%B5%D1%82%D0%BE%D0%BB%D0%BE%D0%B3%D0%BE%D0%B2/

от 6 116 500 руб https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img-20220216-wa0016

Вид материала Цена, за кв https://красивые-дома-приморья.рф/kdp-b-95

м Вид материала Цена, за кв https://красивые-дома-приморья.рф/vypolnennye-proekty/album/monolitno-karkasnyj-dom-44-m2-artem-iyul-2023-g

м Дома из каркаса От 32000 руб https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img_20220505_143155_989

Дома из бруса От 25000 руб https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img_20220908_110515_611

Дома из клееного бруса От 35000 руб https://красивые-дома-приморья.рф/doma-iz-gazobetonnyh-blokov

Дома из профилированного бруса От 25000 руб https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img-20230724-wa0148

Дома из двойного бруса От 25000 руб https://красивые-дома-приморья.рф/doma-iz-gazobetonnyh-blokov

Дома из строганного бруса От 25000 руб https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img-20230723-wa0040

Дома из пеноблоков От 45000 руб https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img-20230724-wa0145

Дома из газоблока От 45000 руб https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img-20220629-wa0064

Дома из керамзитоблоков От 15000 руб https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/55159040_2

Дома из арболитовых блоков От 15000 руб https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img-20220629-wa0053

Дома из силикатных блоков От 45000 руб https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img-20230723-wa0064

Дома из керамических блоков От 45000 руб https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img-20230724-wa0197

Дома из оцилиндрованного бревна От 35000 руб https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img_20220530_104539_476

Дома из кирпича От 45000 руб https://красивые-дома-приморья.рф/vypolnennye-proekty/album/proekt-kdp-1-90-solovej-klyuch-noyabr-2022-g

Дома из лафета От 35000 руб https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img_20220520_202048_514

Дома из SIP панелей От 32000 руб https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img-20230724-wa0136

Дома из ЛСТК От 34000 руб https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img-20230723-wa0069

Дома из газобетона От 45000 руб https://красивые-дома-приморья.рф/vypolnennye-proekty/album/uzkij-dom-152-m2-vladivostok-iyun-2023-g/p/2

Этажность: 2 этажа Срок строительства: от 4 мес https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img_20230528_152949_510

Из профилированного бруса https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img-20220216-wa0051

Некоторые компании при возведении теплой коробки предоставляют смету на оставшийся объем работ по отделке стен, кровли и т https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img-20230723-wa0033

д https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img-20230724-wa0162

, а также на материалы https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img_20211129_134942_552

При необходимости они также могут предоставить собственные скидки на работы и материалы, список подрядчиков https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img-20230723-wa0042

от 720000 руб https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img-20220216-wa0022

курс цена дней 5000 рублей 1 https://москва-курсы.рф/services/obychenie-na-barbera/

11 мин https://москва-курсы.рф/articles/kosmetolog-kto-eto/

• Некрасовка улица Вертолётчиков, 9к1, Москва https://москва-курсы.рф/карта-сайта/

Ближайший старт: 05 Декабря https://москва-курсы.рф/services/%D0%BA%D1%83%D1%80%D1%81-%D0%BF%D0%B5%D1%80%D0%BC%D0%B0%D0%BD%D0%B5%D0%BD%D1%82%D0%BD%D0%BE%D0%B3%D0%BE-%D0%BC%D0%B0%D0%BA%D0%B8%D1%8F%D0%B6%D0%B0/

Курсы • Курсы маникюра •

Подробности курса https://москва-курсы.рф/articles/obychenie-na-estetista-bez-med-obrazovania/

маникюр классический, аппаратный, комбинированный, горячий, бразильский педикюр классический, аппаратный, комбинированный, горячий, бразильский наращивание ногтей по гелевой технологии типсы и нижние формы коррекция нарощенных ногтей снятие нарощенных ногтей спа уходы салонные дизайны (расширенный курс) парафинотерапия вросший ноготь ремонт ногтей покрытие гель-лак под кутикулу, снятие техника массажа рук и ног базовый дизайн, френч, блёстки, стразы https://москва-курсы.рф/services/курсы-парикмахера-модельера-стилист-2/

Сертификат международного образца по окончанию курса https://москва-курсы.рф/articles/gde-vuychitsa-na-barbera/

Беспроцентная рассрочка https://москва-курсы.рф/services/курс-свадебного-стилиста/

Рассрочка предоставляется на срок от трех месяцев https://москва-курсы.рф/services/курсы-косметолога-эстетиста/

Оплачивайте обучение комфортными платежами без переплат https://москва-курсы.рф/services/kursi-kosmetologa-estetista-basoviy/

Более подробную информацию по рассрочке уточняйте у менеджеров https://москва-курсы.рф/services/

Вы также можете оформить быстрый заказ по бесплатному телефону 8 (800) 550-98-50 (ежедневно с 08:00 до 22:00)

Если в планах после обучения устраиваться на работу в салон красоты, то рекомендуется грамотно пользоваться антисептиками, подбирать инструменты, препараты и вещества, которые будут использоваться для деятельности https://москва-курсы.рф/services/французский-пластический-массаж/

Программа обучения https://москва-курсы.рф/политики-конфиденциальности/

Базовый курс https://москва-курсы.рф/services/курс-вечерних-причесок/

Neopravo https://юр-островок.рф/yar/fam/razdel-imushestva-urist

…спасибо вам большое, что были нашим адвокатом на протяжении всего периода решения моего семейного вопроса https://юр-островок.рф/msk/fam/razdel-imushestva-urist

Я рада что вышла на вас https://юр-островок.рф/spb/zpp-urist

Спасибо…

Попал в ДТП и получил травму https://юр-островок.рф/yar/main-urist

В ГИБДД виновника хотели, по-русски говоря, , как мне тогда показалось! Знакомые посоветовали обратиться к адвокату Криворученко Виталию Викторовичу https://юр-островок.рф/ekb/bfl-urist

Справедливость восторжествовала! Спасибо, что помоги мне…

Следует помнить: значительное отклонение стоимости в большую сторону не всегда показатель более высокого качества услуг https://юр-островок.рф/nabchelni/zkh-urist

Стоимость может формироваться и за счет работы хороших специалистов, и аренды красивых офисов в центре города, и больших рекламных бюджетов https://юр-островок.рф/msk/main-urist

Сайт: advokat-arta https://юр-островок.рф/msk/fam/lishenie-roditelskikh-prav-urist

ru Cоцсети: VK, Telegram Телефон: +7 (495) 990-48-79 Адрес: Москва, Краснопролетарская, 30 (стр https://юр-островок.рф/smr/sud-urist

1)

17 отзывов https://юр-островок.рф/srt/bfl-urist

169 https://акваторг24.рф/product/dlina-v-mm/90/

ru https://акваторг24.рф/truby-i-fitingi/ruchnoy-universalnyy-aksialnyy-press-instrument-tim-pink-nasadki-v-komplekte-dlya-truby-16x2-2-20x2-8-25x3-5-32x4-4-art-ft1240a-18/

Наличие и цены уточняйте у наших операторов https://акваторг24.рф/fitingi-dlya-trub/fitingi-rezbovye-dlya-stalnyh-trub/hromirovannye-fitingi/ekstsentrik-s-nakidnoy-gaykoy-hromirovannyy-1-2m-1f-tim-art-k8-xfm042/

© 2011-2023 https://акваторг24.рф/armatura-dlya-radiatorov/krany-dlya-radiatorov/ventil-radiatornyy-pryamoy-tim-s-koltsevym-uplotneniem-polusgona-i-perehodom-na-evrokonus-1-2-x3-4-art-rd202-02e/

Копирование всех составляющих частей сайта в какой бы то ни было форме без письменного разрешения владельцев авторских прав запрещено https://акваторг24.рф/armatura-predohranitelnaya/rele-protoka-servoprivod/termostat-komnatnyy-s-datchikom-vodyanogo-tyoplogo-pola-3m-tim-220v-16a-art-m5-716/

Сайт использует технологию cookie https://акваторг24.рф/armatura-dlya-radiatorov/termostaticheskie-golovki/golovka-termostaticheskaya-zhidkostnaya-tim-m30-1-5-art-th-d-0401/

Используя сайт, Вы соглашаетесь с правилами использования cookie, а также даете согласие на обработку персональных данных https://акваторг24.рф/product/diametr-truby-v-dyuymah/03-04-23/

Среди других преимуществ покупки сантехники в интернет-магазине Водопарад:

Душевые кабины https://акваторг24.рф/product/vid/pryamoy/

Наши цены конкурентоспособны и доступны для каждого клиента https://акваторг24.рф/fitingi-dlya-trub/fitingi-dlya-gofrirovannyh-trub-iz-nerzhaveyuschey-stali-zeissler/mufta-truba-nar-rezba-nikelirovannaya-15-3-4-art-zti-611-001505n/

Мы также предоставляем гарантию на все наши товары и осуществляем доставку по Москве и Московской области https://акваторг24.рф/vodosnabzhenie-vodonagrevateli-filtry/tsirkulyatsionnyy-nasos-tim-aquatim-ekonom-art-am-xps32-6-180/

Интернет-магазин сантехники СВДД https://акваторг24.рф/product/diametr-truby-v-mm/50/

Модульные мини-дома https://красивые-дома-приморья.рф/vypolnennye-proekty/album/gostevoj-dom-s-saunoj-noyabr-2021-g/p/1

Готовые дома и бани для установки в кратчайшие сроки https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img_20220614_142611_733

Нет затрат на отделку https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img_20230528_152949_510

Предлагаем вам строительство домов, дач, бань, бытовых модулей из различных материалов https://красивые-дома-приморья.рф/vypolnennye-proekty/album/proekt-kdp-2-136t

Даже самый дешевый дом должен на 100% соответствовать требованиям по безопасности и комфорту https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img-20220603-wa0020

Ипотечный и кредитный центр

Официальный сайт: www https://акваторг24.рф/truby-i-fitingi/shtutser-latunnyy-trehvyvodnoy-80-mm-tim-1-1-1-3-8-3-8-rezba-vnutr-vnutr-naruzh-art-x003-80/

duim24 https://акваторг24.рф/kollektory-shkafy-komplektuyuschie/kollektornye-gruppy-dlya-tyoplyh-polov/kollektornaya-gruppa-s-rashodomerami-1-3-hoda-nerzh-s-kranami-komplekt-tim-kvadrat-art-kas5003/

ru https://акваторг24.рф/armatura-dlya-radiatorov/multifleksy-dlya-radiatorov-otopleniya/trubka-mvi-dlya-uzla-bokovogo-podklyucheniya-d15h1m-nerzhaveyuschaya-stal-cts-715-04/

Телефон: +7 (800) 100-98-62 Email: info@santehkeram https://акваторг24.рф/protivopozharnye-truby-i-fitingi/protivopozharnye-fitingi-green/mufta-ppr-perehodnaya-vnutrennyaya-naruzhnaya-o75x63-slt-blockfire-zelenyy/

ru Режим работы Пн-Вс с 9:00 до 21:00 https://акваторг24.рф/instrument-i-aksessuary-dlya-montazha/dlya-montazha-polipropilenovyh-trub/nasadka-dlya-payalnika-tim-75mm-art-wm-s75/

Интернет-магазин Home-Santehnika предоставляет своим клиентам отличную возможность купить всю необходимую сантехнику не выходя из дома https://акваторг24.рф/truby-i-fitingi/ugolok-latunnyy-tim-1-1-2-h-1-1-2-rezba-naruzh-vnutr-art-lfm066/

Мы реализуем продукцию премиум-категории и эконом-класса по конкурентоспособным ценам и выполняем её доставку не только по Москве и Московскому региону, но и в любую точку Российской Федерации https://акваторг24.рф/truby-i-fitingi/nasadka-dlya-rasshiritelya-ekspandera-tim-f32x4-7mm-art-n-ro3247/

Транспортировка заказа стоит очень недорого и производится оперативно https://акваторг24.рф/nasosy-i-nasosnoe-oborudovanie/sanitarnye-nasosy/sanitarnyy-nasos-s-izmelchitelem-dlya-otvoda-iz-unitaza-rakoviny-i-dush-vanny-tim-400vt-do-8m-do-145l-min-art-am-stp-400up/

У компании также есть пункт выдачи товаров для тех, кто желает воспользоваться самовывозом https://акваторг24.рф/product/ves-kg/19-4/

Он находится на 18-м километре МКАД в АФ https://акваторг24.рф/product/tolschina-v-mm/4-4/

Преимущества покупок в Home-Santehnika https://акваторг24.рф/nasosy-i-nasosnoe-oborudovanie/komplektuyuschie-dlya-nasosa/rele-suhogo-hoda-dlya-nasosa-tim-1-8-3-0-bar-1-4-g-art-ps-02c/

Каширское шоссе д https://акваторг24.рф/truby-i-fitingi/truba-iz-sshitogo-polietilena-tim-pink-pex-b-20x2-8-s-kislorodnym-barerom-evoh-buhta-200m-art-tpex-2028-200-pink/

19, корпус 1, вход № 3, ТК , магазин 0-D1, 0 этаж https://акваторг24.рф/gidravlicheskie-kollektory-modulnogo-tipa-gorizontalnye/gidravlicheskie-kollektory-modulnye-do-150-kvt/gidravlicheskiy-kollektor-modulnogo-tipa-na-pyat-konturov-gkm-5n-150-chernyy/

О мошенниках или низкокачественных специалистах обязательно найдете негативные отзывы в интернете https://юр-островок.рф/yar/tk-urist

Но помните: наличие единичных заявлений не свидетельствует о непрофессионализме https://юр-островок.рф/spb/zkh-urist

Всегда могут иметь место отзывы и субъективная оценка клиентов, ожидания которых не соответствуют реальности https://юр-островок.рф/smr/zpp-urist

Рейтинг топ-20 лучших юридических компаний Москвы по версии КП https://юр-островок.рф/srt/lawyer-urist

21 мин https://юр-островок.рф/kzn/zem-urist

• Октябрьская улица Шухова, 14, 105 офис; 1 этаж, Москва https://юр-островок.рф/smr/auto-urist

Специализация компании https://юр-островок.рф/msk/auto-urist

Весовой дозатор комбинационный для точного и быстрого дозирования сыпучих и штучных продуктов, который часто называют мультиголовка по принципу работы, производит комбинирование доз в нескольких взвешивающих головках с последующим выбором наиболее близкой к номинальному весу комбинации https://пищевоеоборудование.рф/katalog/izdeliya-iz-nerzh.-stali-aisi304/ramy-koptilnye-aisi-304/ramy-koptilnye-z-aisi-304

Современный весовой дозатор необходим на любом пищевом производстве https://пищевоеоборудование.рф/katalog/izdeliya-iz-nerzh.-stali-aisi304/protivni-dlya-kopcheniya-sushki-aisi-304

При конструировании пищевого оборудования специалисты завода тесно сотрудничают с технологами производств, изучают особенности технологического процесса, рецептуру, технические характеристики оборудования, материалы, способы очистки, максимальный и номинальный объем заполнения, рабочее давление, тип мешалки, вид тепло -, хладоносителя, систему управление, вспомогательное оборудование и т https://пищевоеоборудование.рф/katalog/konvejera-z-obraznye/konvejer-podemnyj-skrebkovyj-kps-3400

д https://пищевоеоборудование.рф/katalog/konvejera-z-obraznye/kopiya-konvejer-s-priemnym-bunkerom-elevator-20001

УДК 664 https://пищевоеоборудование.рф/katalog/oprokidyvateli-kontejnerov-i-telezhek/oprokidyvateli-kontejnerov

143 https://пищевоеоборудование.рф/katalog/izdeliya-iz-nerzh.-stali-aisi304/stol-dlya-inektirovaniya-ryby-aisi-304

7 ТЕХНИЧЕСКОЕ РЕШЕНИЕ ДЛЯ ШЛИФОВАНИЯ СЕМЯН СЕЛЬСКОХОЗЯЙСТВЕННЫХ КУЛЬТУР О https://пищевоеоборудование.рф/katalog/izdeliya-iz-nerzh.-stali-aisi304/stol-dlya-razdelki-aisi-304

Н https://пищевоеоборудование.рф/katalog/konvejera-z-obraznye/kopiya-konvejer-s-priemnym-bunkerom-elevator-20001

Кухарев, И https://пищевоеоборудование.рф/katalog/konvejera-z-obraznye/kopiya-mashina-mojki-sushki-banki-mmsb-2000

Н https://пищевоеоборудование.рф/katalog/oprokidyvateli-kontejnerov-i-telezhek/

Семов В статье рассмотрены актуальные для науки и производства вопросы, связанные с обеспечением

Холодильные витрины и прилавки получили большое распространение в торговле, предприятиях общественного питания и т https://пищевоеоборудование.рф/katalog/centrifuga-reaktivnaya-ustanovka/

д https://пищевоеоборудование.рф/katalog/konvejera-z-obraznye/konvejer-mnogoyarusnyj-dlya-shokovoj-zamorozki

, поэтому сегодня на рынке представлен огромный ассортимент различных моделей данного вида холодильного оборудования https://пищевоеоборудование.рф/katalog/mashina-mojki/mashina-mojki-koptilnyh-veshal-mmkv-500

Плиточные скороморозильные аппараты в свою очередь делятся по способу загрузки продукции на горизонтальные и вертикальные https://пищевоеоборудование.рф/katalog/konvejera-z-obraznye/vibropitatel-s-bunkerom-v-200-l

Они предназначены для переработки рыбной продукции и морепродуктов, мясных продуктов и полуфабрикатов из мяса, а также плодоовощной продукции https://пищевоеоборудование.рф/katalog/slajser-universalnyj-dlya-narezki-myasa-ryby-sl-2000

Т е х н и к а Т Е Х Н И К А УДК 63136 ВН Невзоров, ВН Холопов, ВА Самойлов, АИ Ярум ОПТИМИЗАЦИЯ ПАРАМЕТРОВ И СОВЕРШЕНСТВОВАНИЕ ТЕХНОЛОГИИ ЗЕРНОШЕЛУШЕНИЯ Проведен анализ движения зерна по лопастному ротору

5 шаг https://срочныйвыкуп.com/Personaldatapolicy

Внесение аванса за объект в день обращения https://срочныйвыкуп.com/Personaldatapolicy

- бесплатная консультация и оценка https://срочныйвыкуп.com/personaldatapolicy

В настоящее время срочный выкуп квартир в Москве и Подмосковье — востребованная услуга, но ее предоставляет не каждое агентство недвижимости https://срочныйвыкуп.com/

Осуществить выкуп жилья оперативно, а также срочно продать недвижимость в Москве и Московской области с соблюдением правовых норм Вам поможет агентство ИНКОМ-Недвижимость , имеющее большой опыт работы и безупречную репутацию, о чем свидетельствуют многочисленные отзывы наших клиентов https://срочныйвыкуп.com/personaldatapolicy

Данное соглашение (дальше по тексту – Соглашение) касается Интернет-ресурса с адресом https://срочный-выкуп-недвижимости https://срочныйвыкуп.com/personaldatapolicy

москва/ https://срочныйвыкуп.com/

Действующее Соглашение заключается, чтобы регулировать взаимоотношения Администрации данного портала и его потенциальных Пользователей https://срочныйвыкуп.com/personaldatapolicy

Администрация имеет право изменять, добавлять, удалять пункты из этого Соглашения по своему усмотрению https://срочныйвыкуп.com/

Данные действия вправе делать Администрация портала, при этом Пользователя уведомлять об этом не обязательно https://срочныйвыкуп.com/Personaldatapolicy

Пользуясь Сайтом, его Пользователь соглашается с такими условиями настоящего документа и изменений, вносящихся в него https://срочныйвыкуп.com/personaldatapolicy

Пользователь ресурса самостоятельно будет проверять изменения в данном Соглашении https://срочныйвыкуп.com/

Ответственность полностью ложится на Пользователя https://срочныйвыкуп.com/personaldatapolicy

Оставьте заявку и наш менеджер проконсультирует вас!

Порядок работы выкуп квартиры за 7 дней https://срочныйвыкуп.com/

От рождения до заселения с компанией

Барнхаус https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/576317507

Строим в любое время года!

• Фундамент https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/576317507

Выбирается буронабивной с показателями как у теплой коробки https://красивые-дома-приморья.рф/vypolnennye-proekty/album/dom-113-m2-p-mirnyj-iyun-2023-g

• Теплая коробка https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img-20230723-wa0064

Стены и потолок с соответствующей отделкой, указанной ранее https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img-20220217-wa0000

• Двускатная утепленная кровля https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img-20230724-wa0205

В качестве утеплителя выбирается минеральная вата https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img_20210914_113207_869

Покрывается металлочерепицей https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img_20220518_120137_340

• Водосточная система, подшивка кровли софитами, вентиляция https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img_20220908_110515_611

Все это требует тщательной проработки проекта, чтобы у владельца дома в будущем не возникало проблем https://красивые-дома-приморья.рф/vypolnennye-proekty/album/karkasnyj-dom-78-m2-knevichi-iyul-2022-g

• Окна ПВХ https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img-20230723-wa0071

Это двухкамерный стеклопакет, обрамленный пятикамерным профилем https://красивые-дома-приморья.рф/vypolnennye-proekty/album/dom-113-m2-p-mirnyj-iyun-2023-g

Есть металлические отливы https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img-20230724-wa0209

• Дверь входная https://красивые-дома-приморья.рф/kdp-1-120

Имеет терморазрыв, утепленная https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img_20211129_134942_552

• Стяжка пола https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img-20230724-wa0162

Производится на первом этаже https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img_20220520_201449_291

• Фасад https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img_20211113_143244_265

По проекту можно запланировать декоративные элементы, а стандарт предполагает окраску по бетону https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img_20210914_113207_869

• Перегородки с/у https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img_20211106_144233_087

Делаются на первом этаже https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img_20220520_192009_057

Живите ближе к природе! А мы позаботимся о вашем комфорте https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img-20230724-wa0156

г https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/lenovo-580-1

Владивосток, ул https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img_20230528_152949_510

Приморская, 6, стр https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img-20220603-wa0006

3 г https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img-20230724-wa0146

Находка, ул https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img_20220518_120137_340

Шоссейная д https://красивые-дома-приморья.рф/vypolnennye-proekty/album/karkasnyj-dom-78-m2-knevichi-iyul-2022-g

148 г https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img_20210918_164348_416

Уссурийск, ул https://красивые-дома-приморья.рф/santehnicheskie-raboty

Кузнечная, д https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img_20220505_143155_989

14 п https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img-20230723-wa0033

Угловое, ул https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img-20220615-wa0008

Гагарина, д https://красивые-дома-приморья.рф/vypolnennye-proekty/album/dom-113-m2-p-mirnyj-iyun-2023-g/p/2

90 https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img-20230724-wa0141

Стрейч пленку используют на комбинатах пищевой промышленности, в фасовочных отделах, для упаковки мелкогабаритного товара https://рускачество.com/kak-my-rabotaem/

Она защищает продукты от любых видов загрязнения, попадания влаги и пыли, болезнетворных микроорганизмов из окружающей среды https://рускачество.com/states/armirovannaja-pljonka/

ПЭ пленка широко применяется для обустройства парников и теплиц https://рускачество.com/

Хорошо удерживает тепло внутри сооружений, создаёт благоприятный микроклимат для роста и развития растений https://рускачество.com/prodazha-tentov-tarpaulin/

Воздушно-пузырчатый полиэтиленовый материал применяют для упаковки и сохранности любого вида товара https://рускачество.com/stroitelnye-tenty-i-pologi-primenenie/

Воздушный слой обеспечивает целостность груза при перевозке https://рускачество.com/states/

Особо прочная армированная пленка подходит для устройства бассейнов, навесов, дорожных покрытий https://рускачество.com/states/armirovannaja-pljonka/

Выдерживает значительные механические нагрузки, ветер, атмосферные осадки https://рускачество.com/

Снижайте затраты на строительство благодаря поставкам от официального производителя и отсутствия посреднических наценок https://рускачество.com/states/

Цена руб https://рускачество.com/states/

/ кв https://рускачество.com/privacy-policy/

м https://рускачество.com/prodazha-plenki-armirovannoj/

:

Цена, руб https://рускачество.com/privacy-policy/

/ кг:

Рекомендации по выбору https://рускачество.com/states/

Цена руб https://рускачество.com/states/armirovannaja-pljonka/

/ пог https://рускачество.com/states/armirovannaja-pljonka/

м https://рускачество.com/stroitelnye-tenty-i-pologi-primenenie/

:

УДК 631 https://пищевоеоборудование.рф/katalog/defroster-vodyanoj-dvg-1000/

362 Техника и технологии продуктов питания: ЦЕНТРОБЕЖНЫЙ КАСКАДНЫЙ РЕШЕТНЫЙ СЕПАРАТОР ДЛЯ ОЧИСТКИ ЗЕРНА С https://пищевоеоборудование.рф/katalog/konvejera-z-obraznye/skrebkovyj-konvejer-sk-304

В https://пищевоеоборудование.рф/katalog/oprokidyvateli-kontejnerov-i-telezhek/oprokidyvatel-cepnoj-orc-3000

Батуева 1, С https://пищевоеоборудование.рф/katalog/konvejera-z-obraznye/konvejer-cepnoj-dlya-banok-kcb-z

С https://пищевоеоборудование.рф/katalog/oprokidyvateli-kontejnerov-i-telezhek/oprokidyvateli-telezhek

Ямпилов 2 (Восточно-Сибирский государственный университет технологии

Серия загрузочных клапанов мусоропровода - бюджетная модель, выполненная из стали толщиной 1,5 мм https://пищевоеоборудование.рф/katalog/oprokidyvateli-kontejnerov-i-telezhek/oprokidyvateli-cheburashek-och-250

Диаметр ствола мусоропровода 400-450 мм https://пищевоеоборудование.рф/o-kompanii

Высота – 770 мм https://пищевоеоборудование.рф/katalog/konvejera-z-obraznye/

В настоящее время пищевая промышленность неуклонно развивается и для ее нормальной работы обязательно требуется приобретение и создание не только новой компании, но и обязательно приобретение необходимого пищевого оборудования https://пищевоеоборудование.рф/katalog/konvejera-z-obraznye/

Одним из таких видов оборудования являются , которые выпускается заводом – изготовителем https://пищевоеоборудование.рф/katalog/centrifuga-reaktivnaya-ustanovka/centrifuga-ikornaya-ck-20

На данном сайте представлены не только все виды пищевого оборудования, но также еще и предлагаются невысокие цены, так как такое оборудование всегда находится в легком доступе https://пищевоеоборудование.рф/katalog/konvejera-z-obraznye/konvejer-cepnoj-z-3500

УДК 636 https://пищевоеоборудование.рф/katalog/defroster-vodyanoj-dvg-1000/defroster-vodyanoj-dvg-500

22 https://пищевоеоборудование.рф/katalog/konvejera-z-obraznye/konvejer-inspekcionnyj-ki-3500

014 МОДЕЛИРОВАНИЕ МОЩНОСТИ ВЕРТИКАЛЬНОГО ЛОПАСТНОГО СМЕСИТЕЛЯ НА ОСНОВЕ СТАТИСТИЧЕСКИХ ВЫРАЖЕНИЙ Фомина М https://пищевоеоборудование.рф/katalog/bunkera-nakopitelnye-priemnye/bunker-smesitelnyj-tip-bs-80-aisi-304

В https://пищевоеоборудование.рф/katalog/centrifuga-reaktivnaya-ustanovka/centrifuga-ikornaya-ck-20

, Коновалов В https://пищевоеоборудование.рф/katalog/konvejera-z-obraznye/kopiya-konvejer-s-priemnym-bunkerom-elevator-20001

В https://пищевоеоборудование.рф/katalog/sanpropuskniki-doz-200/dezbarery-dlya-avtotransporta-doz-m-5000

, Чупшев А https://пищевоеоборудование.рф/katalog/centrifuga-reaktivnaya-ustanovka/centrifuga-filtracionnaya-cf-1000

В https://пищевоеоборудование.рф/katalog/oprokidyvateli-kontejnerov-i-telezhek/oprokidyvateli-telezhek

, Терюшков В https://пищевоеоборудование.рф/katalog/centrifuga-reaktivnaya-ustanovka/centrifuga-s-odnoj-korzinoj-ck-30

П https://пищевоеоборудование.рф/katalog/kotel-pishhevarochnyj-s-meshalkoj-kpm-100/kotel-pishhevarochnyj-s-meshalkoj-kpm-r-100

В работе представлены результаты

общественного питания), торговое (предназначено для охлаждения и демонстрации продукции в торговых точках, кафе, барах) и складское (используется для хранения пищевых продуктов в магазинах, ресторанах, на производственных предприятиях) https://пищевоеоборудование.рф/katalog/oprokidyvateli-kontejnerov-i-telezhek/oprokidyvatel-cepnoj-orc-3000

У нас Вы можете приобрести холодильное оборудование для любых целей по привлекательным ценам https://пищевоеоборудование.рф/katalog/konvejera-z-obraznye/konvejer-odnourovnevyj-pvh-3000

Размер рулона, м:

Пленка МИКСТ Пленка МИКСТ СТАНДАРТ Пленка полиэтиленовая прозрачная весовая ПВХ Пленка Пленка прозрачная Пленка прозрачная техническая Пленка черная Пленка черная техническая Пленка многолетняя Силосная пленка Пленка для водоемов Воздушно-пузырчатая пленка https://рускачество.com/privacy-policy/

В каталоге магазина “Оптимальное соотношение” представлены различные виды пленки высокого качества, среди которых МИКСТ, прозрачная весовая и прозрачная техническая, черная и черная техническая, многолетняя, силосная, воздушно-пузырчатая и другие https://рускачество.com/states/armirovannaja-pljonka/

Они различаются по характеристикам и, соответственно, по методу применения https://рускачество.com/states/tenty/

И если одни виды идеально подходят для упаковки, другие станут незаменимым укрывным полотном на стройплощадке, а третьи представляют собой отличный тепличный материал https://рускачество.com/prodazha-pervichnoj-i-vtorichnoj-tehnicheskoj-pljonki/

Спасибо, Ваш голос учтен!

добавить к сравнению перейти к сравнению (-1)

Цвет: черный https://рускачество.com/prodazha-plenki-armirovannoj/

В Москве и Подмосковье имеется 6 офлайн-магазинов, где покупатель может лично ознакомиться с ассортиментом, проконсультироваться со специалистов насчет выбора оборудования, его установки и эксплуатации https://акваторг24.рф/nasosy-i-nasosnoe-oborudovanie/skvazhnye-nasosy/

Наша компания является официальным диллером известных брендов - мы предлагаем широкий ассортимент товаров по самым выгодным ценам! Поставки физическим и юридическим лицам в Москве и по России https://акваторг24.рф/zapornaya-radiatornaya-kotelnaya-armatura/ventil-ruchnoy-regulirovki-uglovoy-1-2-s-antiprotechkoy-zeissler-tim-art-rs201-02-me001/

ванны, унитазы, писсуары, биде, душевые кабины, поддоны и боксы; мебель для ванной комнаты (тумбы, зеркала, пеналы и т https://акваторг24.рф/product/ves-kg/d/

д https://акваторг24.рф/protivopozharnye-truby-i-fitingi/protivopozharnye-fitingi-red/zaglushka-ppr-o110-slt-blockfire/

); раковины и мойки, аксессуары для ванной и кухни; смесители, душевые комплекты и гарнитуры, гигиенические души; комплектующие для сантехники, фитинги, арматура, инсталляции и т https://акваторг24.рф/lotki-sifony-trapy-shlangi-podvodka-dlya-vody-tim/shlang-dlya-dusha-i-izliv/page/2/

д https://акваторг24.рф/gidravlicheskie-razdeliteli-modulnogo-tipa-do-60-kvt-ploschad-do-400-kv-m/gidravlicheskiy-razdelitel-grm-3-60/

Мы стараемся максимально сократить время на доставку и сделать крайне низкими стоимость доставки https://акваторг24.рф/truby/truby-iz-sshitogo-polietilena-pex/truba-iz-sshitogo-polietilena-pex-a-s-antikislorodnym-barerom-evoh-20-2-8-buhta-200-m-mvi-art-re-420-05/

Более подробно с условиями доставки вы можете ознакомиться тут https://акваторг24.рф/armatura-zapornaya/krany-sharovye-dlya-vody/krany-sharovye-mvi/kran-sharovoy-uglovoy-polnoprohodnoy-mvi-3-4-s-amerikankoy-nar-vn-rezboy-ruchka-babochka-krasnaya-art-bv-522-05/

Магазин работает как с частными, так и с корпоративными клиентами (строительными и ремонтными компаниями, дизайн-агентствами и т https://акваторг24.рф/protivopozharnye-truby-i-fitingi/protivopozharnye-fitingi-green/otvod-ppr-o125x90-slt-blockfire-segmentnyy-sdr-11-zelenyy/

д https://акваторг24.рф/instrument-i-aksessuary-dlya-montazha/dlya-montazha-trub-iz-sshitogo-polietilena-pex/akkumulyatornyy-rasshiritelnyy-instrument-s-golovkami-dlya-sistemy-q-e-tim-art-ft-m12-1632/

) Для последних предусмотрены специальные предложения после регистрации на сайте https://акваторг24.рф/truby-i-fitingi/hromirovannyy-latunnyy-ugolok-dlya-polotentsesushiteley-tim-3-4-x3-4-rezba-vnutr-naruzh-art-k3-lfm033/

Склад плитки адрес: г https://акваторг24.рф/zapornaya-radiatornaya-kotelnaya-armatura/filtr-samopromyvnoy-tim-3-4-naruzh-naruzh-rezba-s-amerikankami-ruchnaya-obratnaya-promyvka-art-jh-2002r/

Москва, улица Вторая Лыковская 63 https://акваторг24.рф/zapornaya-radiatornaya-kotelnaya-armatura/trehhodovoy-termostaticheskiy-klapan-tim-1-n-art-bl7661x04/

Качественные фотографии облегчат подбор, подробные описания дадут полную информацию: положительные отзывы, накопившиеся за годы работы, говорят сами за себя https://акваторг24.рф/zapornaya-radiatornaya-kotelnaya-armatura/kran-sharovoy-polnoprohodnoy-mvi-1-2-s-kosym-setchatym-filtrom-s-vn-vn-rezboy-ruchka-rychag-krasnaya-art-bv-631-04/

Наш интернет-магазин неизменно получает положительные отзывы о своей работе https://акваторг24.рф/filtry/filtry-muftovye-gryazeviki/filtr-kosoy-tim-c-mini-kranom-1-2-ff-vn-vn-art-bl-d7604/

И это закономерно – у нас:

CRETO https://акваторг24.рф/product/ves-netto-kg/0-156/

Купить необходимый товар не составит большого труда https://акваторг24.рф/vodosnabzhenie-vodonagrevateli-filtry/nasosnaya-stantsiya-tim-aquatim-600vt-35m-napor-50l-min/

Достаточно просто зайти на сайт интернет-магазина инженерной сантехники имеют очень высокую квалификацию, что дает им возможность максимально точно и профессионально консультировать покупателей https://акваторг24.рф/armatura-dlya-otopleniya/klapana-balansirovochnye/

Также персонал всегда идет в ногу со временем, повышая свою квалификацию на специализированных семинарах https://акваторг24.рф/truby/polipropilenovye-truby-slt-aqua-polipropilenovye-truby-slt-aqua/polipropilenovye-truby-dlya-vodosnabzheniya/truba-slt-aqua-pp-r-pn20-d25h4-2-sdr6-4-m-4sltps625/

В интернет-магазине представлены лучшие распродажа и тысячи других моделей сантехники ведущих мировых брендов https://акваторг24.рф/product/vid-tovara/trehhodovye-i-termostaticheskie-smesitelnye-klapany/

Удобство заказа, фотографии товаров, подробные технические характеристики сантех изделий и отзывы покупателей помогут выбрать нужные распродажа https://акваторг24.рф/fitingi-dlya-trub/aksialnye-fitingi/

Распродажа с доставкой по Москве и другим городам России быстро и надежно с интернет-магазином www https://акваторг24.рф/armatura-dlya-otopleniya/elektroprivody/

vodoparad https://акваторг24.рф/vodosnabzhenie-vodonagrevateli-filtry/kanalizatsionnyy-nasos-tim-s-izmelchitelem-100-l-min-art-am-stp-400/

ru https://акваторг24.рф/lotki-sifony-trapy-shlangi-podvodka-dlya-vody-tim/shlang-dlya-dusha-i-izliv/shlang-dlya-dusha-dvoy-zamkami-s-armir-rezinoy-v-opletke-1-2-175sm-lux-tim-art-c-m175-3-lux/

Юридические услуги • Юридическая консультация •

17 отзывов https://юр-островок.рф/msk/fam-urist

Юридические услуги • Консультация адвоката •

Телефон: +7 (499) 238-60-07 Адрес: Москва, Большая Полянка, 43 https://юр-островок.рф/ekb/main-urist

Хочу выразить огромную благодарность сотрудникам Юридической компании Наталье Гиоргиевне и Евгению Александрович за отличную работу, за высокий профессионализм https://юр-островок.рф/spb/fam-urist

…

8 мин https://юр-островок.рф/yar/zkh-urist

• Преображенская площадь Преображенская площадь, 7Ас1, офис 003, Москва https://юр-островок.рф/kzn/fam/lishenie-roditelskikh-prav-urist

Без полиэтиленовой пленки (прозрачной, черной) в настоящее время не обходятся ни строительные, ни ремонтные работы https://рускачество.com/

Она необходима и в сельском хозяйстве, где используется для возведения теплиц и парников, силосных ям и овощехранилищ https://рускачество.com/states/tenty/

Субъект персональных данных может отозвать свое согласие, следуя по специальной ссылке в сообщениях от ООО https://рускачество.com/prodazha-tentov-tarpaulin/

В качестве гидро- и пароизолятора при строительстве требуется очень крепкое полотно https://рускачество.com/prodazha-pervichnoj-i-vtorichnoj-tehnicheskoj-pljonki/

Таким критериям соответствует изделие в 200 мкм https://рускачество.com/states/

Можно получить полотно любого размера, если сварить шов специальным устройством, которое выдаёт высокую температуру https://рускачество.com/tenty-tarpaulin-vidy-i-preimushhestva/

Экономичная замена битумным гидроизоляторам https://рускачество.com/stroitelnye-tenty-i-pologi-primenenie/

В строительной отрасли чаще применяют пленку техническую полиэтиленовую, а также ПЭ высшего и первого сорта, полотно чёрного цвета https://рускачество.com/prodazha-plenki-armirovannoj/

Цена руб https://рускачество.com/prodazha-pervichnoj-i-vtorichnoj-tehnicheskoj-pljonki/

/ пог https://рускачество.com/states/armirovannaja-pljonka/

м https://рускачество.com/prodazha-tentov-tarpaulin/

:

Длина рулона, м:

Пленка полиэтиленовая https://рускачество.com/armirovannaja-plenka-dlja-teplic/

Адвокатский кабинет Маркина Александра Викторовича https://юр-островок.рф/smr/bfl-urist

Адвокатский кабинет Криворученко Виталия Викторовича https://юр-островок.рф/srt/zem-urist

— люди, признанные судом недееспособными, а также их законные представители, если они обращаются за оказанием бесплатной юридической помощи по вопросам, связанным с обеспечением и защитой прав и законных интересов таких граждан;

Лучшие юридические компании России https://юр-островок.рф/msk/tk-urist

Фото: shutterstock https://юр-островок.рф/yar/nasl-urist

com https://юр-островок.рф/yar/nasl-urist

Контакты https://юр-островок.рф/nabchelni/zem-urist

Приём осуществляется по предварительной записи https://юр-островок.рф/nabchelni/fam-urist

Выберите готовый дом https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img_20221125_164946_154

разработку проектов; строительство домов под ключ из разных материалов; внутренняя и наружная шлифовка зданий; сооружение фундамента и кровель; постройка ограждений и другие услуги https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img-20220629-wa0058

Строительство домов во Владивостоке https://красивые-дома-приморья.рф/karkasnye-doma

Проект ГБД-113 https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/wp_20170330_001

Модульные мини-дома: воплотить мечты о своем жилье стало еще проще!

Подготовка площадки https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img_20211129_141803_480

Я установил кованые перила и в дом, и на улицу https://московская-ковка.рф/tovary/kovanye-perila-s-bokovym-krepleniem-artikul-kp-2022-20/

Все очень красиво и я рекомендую Вас всем соседям https://московская-ковка.рф/tovary/perila-kovannye-artikul-kp-178/

Спасибо https://московская-ковка.рф/tovary/vypuklye-kovanye-perila-dlya-balkona-artikul-kp-117/

Кованые перила на крыльцо дома в ТСН Сосновый бор https://московская-ковка.рф/tovary/kovanye-arochnye-kozyrki-artikul-033/

Кованые заборы https://московская-ковка.рф/tovary/kovanye-perila-dlya-balkona-artikul-kp-091/

Кованые козырьки https://московская-ковка.рф/tovary/kovanye-vorota-s-kalitkoj-artikul-kv-116/

Кованый балкон с цветочницами КБА-27 https://московская-ковка.рф/tovary/kovanye-perila-artikul-kp-138/

Цена : от 2 500 руб https://московская-ковка.рф/tovary/vozdushnye-latunnye-perila-dlja-lestnicy-artikul-kp-2024-14/

м/ пог https://московская-ковка.рф/tovary/vorota-s-geometricheskim-risunkom-artikul-kv-124/

ЛУЧШЕЕ ОБСЛУЖИВАНИЕ https://рускачество.com/prodazha-plenki-armirovannoj/

Цена руб https://рускачество.com/prodazha-pervichnoj-i-vtorichnoj-tehnicheskoj-pljonki/

/ кв https://рускачество.com/stroitelnye-tenty-i-pologi-primenenie/

м https://рускачество.com/kak-my-rabotaem/

:

Материал : Рукав 1,5 - 2 - 3 м https://рускачество.com/prodazha-tentov-tarpaulin/

Цена, руб https://рускачество.com/states/

/ кг:

Технические характеристики https://рускачество.com/

Цена, руб https://рускачество.com/tenty-tarpaulin-vidy-i-preimushhestva/

/ упаковка:

наших специалистов помогут сделать оптимальный выбор оборудования, будь то небольшая упаковочная машина или же многофункциональное пищевое оборудование,

УДК 678 https://пищевоеоборудование.рф/katalog/kamera-df/kamera-defrostacii-kd-4000

058:539 https://пищевоеоборудование.рф/katalog/mashina-mojki/kopiya-mashina-mojki-tary-msh-204

4 ВЛИЯНИЕ ПОДВУЛКАНИЗАЦИИ НА ОТНОСИТЕЛЬНОЕ ИЗМЕНЕНИЕ РАЗМЕРОВ ДЛИННОМЕРНЫХ РЕЗИНОТЕХНИЧЕСКИХ ЗАГОТОВОК М https://пищевоеоборудование.рф/katalog/bunkera-nakopitelnye-priemnye/farshemeshalka-smesitel-tip-farsh-2-150-aisi-304

В https://пищевоеоборудование.рф/katalog/mashina-mojki/

Соколов, А https://пищевоеоборудование.рф/katalog/defroster-vodyanoj-dvg-1000/

С https://пищевоеоборудование.рф/katalog/centrifuga-reaktivnaya-ustanovka/centrifuga-s-odnoj-korzinoj-ck-30

Клинков, П https://пищевоеоборудование.рф/katalog/konvejera-z-obraznye/konvejera-razdelochnye-inspekcionnye

С https://пищевоеоборудование.рф/katalog/trapy-zhirouloviteli-napolnye-aisi-304/reshetki-yacheistye-aisi-304

Беляев, В https://пищевоеоборудование.рф/katalog/konvejera-z-obraznye/kopiya-konvejer-s-priemnym-bunkerom-elevator-2000

Г https://пищевоеоборудование.рф/katalog/oprokidyvateli-kontejnerov-i-telezhek/oprokidyvatel-cepnoj-orc-3000

Однолько ГОУ ВПО «Тамбовский государственный

Предназначен для первичной обработки молока и сметаны, упаковки молока в полиэтиленовые пакеты, упаковки сметаны в стаканчики из полистирола Цена товара с учетом НДС: 1601146 руб https://пищевоеоборудование.рф/katalog/sanpropuskniki-doz-200/promyshlennaya-sushilka-dlya-obuvi-baktericidnaya-prom-sush-30

Упаковка делится на технологическую и упаковочную https://пищевоеоборудование.рф/katalog/kamera-df/kamera-defrostacii-kd-cold-8000

Речь идет как об упаковке продуктов в конечную тару, так и технологической упаковке, позволяющей транспортировать товар и доставлять его в неповрежденном виде https://пищевоеоборудование.рф/katalog/mashina-mojki/

Существует целый ряд готовых решений, которые предлагаются по востребованным ценам https://пищевоеоборудование.рф/katalog/sortirovka-valkovaya-sort-7/

Рынок упаковки постоянно расширяется https://пищевоеоборудование.рф/katalog/oprokidyvateli-kontejnerov-i-telezhek/oprokidyvateli-bochek-ob-250

Г https://пищевоеоборудование.рф/katalog/trapy-zhirouloviteli-napolnye-aisi-304/

В https://пищевоеоборудование.рф/katalog/izdeliya-iz-nerzh.-stali-aisi304/

Серга, д-р техн https://пищевоеоборудование.рф/katalog/mashina-mojki/mashina-mojki-ryby-orehov-mm-2000

наук, проф https://пищевоеоборудование.рф/katalog/konvejera-z-obraznye/konvejer-fasovochnyj-kf-3500

, А https://пищевоеоборудование.рф/katalog/oprokidyvateli-kontejnerov-i-telezhek/big-boksy

Ю https://пищевоеоборудование.рф/katalog/sanpropuskniki-doz-200/dezbarery-dlya-avtotransporta-doz-m-5000

Марченко, канд https://пищевоеоборудование.рф/katalog/kamera-df/

техн https://пищевоеоборудование.рф/katalog/slajser-universalnyj-dlya-narezki-myasa-ryby-sl-2000

наук, доцент Кубанский государственный аграрный университет им https://пищевоеоборудование.рф/katalog/konvejera-z-obraznye/konvejer-fasovki-produkcii-v-banku-kfb-3

И https://пищевоеоборудование.рф/katalog/mashina-mojki/kopiya-mashina-mojki-tary-msh-204

Т https://пищевоеоборудование.рф/o-kompanii

Трубилина, Россия, 350044, г https://пищевоеоборудование.рф/katalog/konvejera-z-obraznye/konvejer-fasovki-produkcii-v-banku-kfb-3

Краснодар, ул https://пищевоеоборудование.рф/katalog/glazirovshhiki-pogruzhnoj/

Калинина 13 ПРОГРЕССИВНЫЕ

ISSN 1993-8322 https://пищевоеоборудование.рф/katalog/centrifuga-reaktivnaya-ustanovka/centrifuga-reaktivnaya-ustanovka-rc-1500

ВІСНИК Донбаської державної машинобудівної академії https://пищевоеоборудование.рф/katalog/konvejera-z-obraznye/konvejer-podemnyj-skrebkovyj-kps-3400

4 (25), 2011 https://пищевоеоборудование.рф/katalog/bunkera-nakopitelnye-priemnye/farshemeshalka-smesitel-tip-farsh-150-aisi-304

251 УДК 621 https://пищевоеоборудование.рф/katalog/glazirovshhiki-pogruzhnoj/glazirovshhik-pogruzhnoj-gl-n-600

883 Красовский С https://пищевоеоборудование.рф/

С https://пищевоеоборудование.рф/katalog/konvejera-z-obraznye/konvejer-mnogoyarusnyj-dlya-shokovoj-zamorozki

КЛАССИФИКАЦИЯ КОНСТРУКЦИЙ УДАРНО-ИМПУЛЬСНЫХ МЕХАНИЗМОВ Вопросы анализа конструкций ударно-импульсных

Интернет-магазин сантехники СВДД https://акваторг24.рф/instrument-i-aksessuary-dlya-montazha/press-instrument/nasadka-dlya-press-instrumenta-elektricheskogo-standart-v-18mm-zissler-art-zti-591v-18/

МедМаг24 https://акваторг24.рф/product/tolschina-v-mm/6/

На всю продукцию в Дюйме предоставляется гарантия, по которой покупатель может заменить бракованную сантехнику или отремонтировать ее в сервисных центрах компаний-производителей https://акваторг24.рф/kollektory-shkafy-komplektuyuschie/kollektornye-gruppy-dlya-radiatorov/kollektor-mvi-bez-rashodomerov-c-drenazhnym-kranom-i-vozduhootvodchikom-na-2-vyh-art-ms-602-06/

На страницах товаров имеются подробные описания моделей и детальные фото товаров https://акваторг24.рф/protivopozharnye-truby-i-fitingi/protivopozharnye-fitingi-red/troynik-polipropilenovyy-ppr-o160-slt-blockfire-segmentnyy-sdr-7-4/

Десятки тысяч покупателей уже убедились в безупречном качестве услуг и самой сантехники напрямую от производителей https://акваторг24.рф/armatura-zapornaya/krany-sharovye-dlya-vody/krany-sharovye-mvi/kran-sharovoy-sadovyy-polnoprohodnoy-mvi-1-2-so-shtutserom-ruchka-rychag-krasnaya-art-bv-633-04/

Распродажа на выбор с максимально подходящими вашим требованиям уже ждут вас!

Мы стараемся продавать исключительно 100% качественный товар , именно за это наши клиенты и ценят нас https://акваторг24.рф/gidravlicheskie-kollektory-modulnogo-tipa-gorizontalnye/gidravlicheskie-kollektory-modulnye-do-100-kvt/gidravlicheskiy-kollektor-modulnogo-tipa-na-pyat-konturov-gkm-5n-100-chernyy/

Мы всегда подходим индивидуально к каждому нашему клиенту и стараемся максимально полно и качественно удовлетворить каждое его пожелание!

Случайно нашла компанию https://акваторг24.рф/instrument-i-aksessuary-dlya-montazha/materialy-rashodnye/poliamidnaya-nit-tim-20m-art-mb02-c20-art-mb02-c20/

Нужен был угловой стол с ящиками и местом для принтера и всё под мои размеры и цвет материалов, чтобы смотрелся комплектом под имеющиеся мебель под заказ https://акваторг24.рф/truby-i-fitingi/hromirovannyy-sgon-latunnyy-1-2-x1-2-150mm-art-a-sm022-150/

Заказывать на сайте достаточно удобно, есть конструктор, в котором…

СНТ Серебряный Ключ https://красивые-дома-приморья.рф/vypolnennye-proekty/album/proekt-kdp-b-97

от 3300000 руб https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img_20220520_202048_514

Для этого мы предоставим Вам детальную смету на оставшиеся работы по дому (по кровле, окнам, окраске фасада, отделочным работам) с объемами и стоимостью работ и материалов, а также предоставим Вам свои дилерские скидки!

от 13 500 руб https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img-20230723-wa0071-1

за квадратный метр https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img_20230327_150313_855

Этажность: 2 этажа Срок строительства: от 4 мес https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img_20220530_104539_476

• Подберем выгодную кредитную программу https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img-20220621-wa0003

Вероятность одобрения - 99%!

• Фундамент https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img-20230724-wa0159

Выбирается буронабивной с показателями как у теплой коробки https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img-20230724-wa0194

• Теплая коробка https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/576317507

Стены и потолок с соответствующей отделкой, указанной ранее https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img_20220420_094206_921

• Двускатная утепленная кровля https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img-20220603-wa0007

В качестве утеплителя выбирается минеральная вата https://красивые-дома-приморья.рф/banya-30-60

Покрывается металлочерепицей https://красивые-дома-приморья.рф/kdp-112

• Водосточная система, подшивка кровли софитами, вентиляция https://красивые-дома-приморья.рф/kdp-112

Все это требует тщательной проработки проекта, чтобы у владельца дома в будущем не возникало проблем https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img_20220518_120137_340

• Окна ПВХ https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img_20220520_192009_057

Это двухкамерный стеклопакет, обрамленный пятикамерным профилем https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img-20230723-wa0071

Есть металлические отливы https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img-20230723-wa0034

• Дверь входная https://красивые-дома-приморья.рф/vypolnennye-proekty/album/proekt-kdp-b-97

Имеет терморазрыв, утепленная https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img_20221125_164946_154

• Стяжка пола https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img-20230724-wa0140

Производится на первом этаже https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/576317707

• Фасад https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img_20220530_104539_476

По проекту можно запланировать декоративные элементы, а стандарт предполагает окраску по бетону https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img-20230724-wa0149

• Перегородки с/у https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img-20230724-wa0201

Делаются на первом этаже https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/wp_20170330_002

от 12 656 800 руб https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img_20230528_183202_837

возводим загородные дома, дачи и бани https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img-20230724-wa0194

от 9 316 800 руб https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/576317507

Материалы для строительства домов во Владивостоке под заказ https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/imag0191

Деревянные изделия 100% экологичны, не содержат клея, формальдегидных смол и синтетических дополнений https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/lenovo-2173

Сэндвич-панели имеют сертификаты качества, не токсичны и могут применяться для пищевых и медучреждений https://красивые-дома-приморья.рф/vypolnennye-proekty/photo/img_20211129_141803_480